تلاش دانشمندان برای رفع پیشداوری و جانبداری هوش مصنوعی

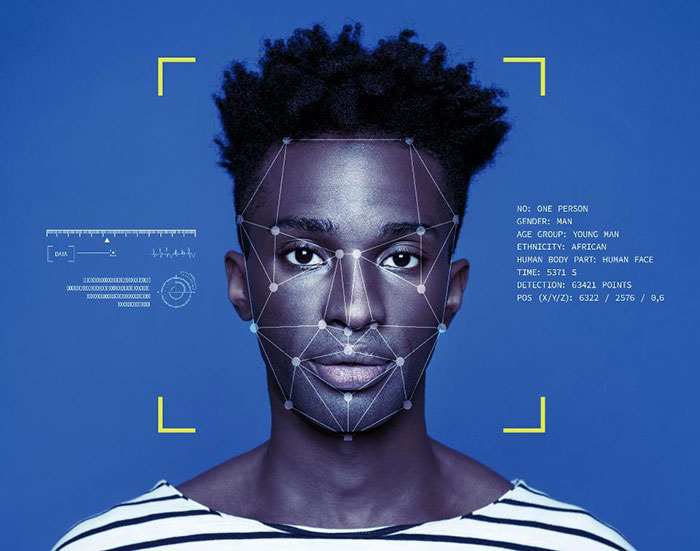

در سالهای اخیر، کامپیوترها بهلطف جهشها و پیشرفتهای چشمگیر هوش مصنوعی، دنیای اطراف را با وضوح بیشتری میبینند؛ اما ممکن است انسان با آگاهی از ذهنیت هوش مصنوعی نسبت به خود، شگفتزده و حتی ناامید شود. طبق آزمایشهای جدید، بهترین سیستم بینایی هوش مصنوعی با دیدن تصویر چهرهی شخص ممکن است شروع به فحاشی نژادی، بیان کلیشههای جنسیتی یا اصطلاحاتی کند که شخصیت اصلی افراد را انکار میکند.

درنتیجه دانشمندان به ماشینها آموزش دادند تا پیشداوریهای انسانی را که ریشه در دادههای به کار رفته دارند، از بین ببرند. چنین تغییراتی به بهبود ذهنیت عادلانهی هوش مصنوعی کمک میکنند؛ اما تلاشها نشان میدهند حذف انحراف از سیستمهای هوش مصنوعی هنوز هم کار دشواری است و بخشی از این دشواری به انسانهایی برمیگردد که به این سیستمها آموزش میدهند. الگا روساکفسکی، استادیار دانشگاه پرینستون و یکی از پژوهشگران بررسی میگوید: «وقتی وارد لایههای عمیقتر میشوید باید نکات بیشتری را در نظر بگیرید.»

پروژهی یادشده بخشی از تلاشی وسیع برای درمان سیستمهای خودکار و رفع انحرافها و پیشداوریهای مخفی چنین سیستمهایی است. این مسئله از اهمیت بالایی برخوردار است چرا که هوش مصنوعی به سرعت در حال گسترش بوده و میتواند آثاری جدی را بر زندگی انسان بهجای بگذارد. انحراف در سیستمهای تشخیص چهره، برنامههای استخدامی و الگوریتمهای جستجوی وب شناسایی شده است. سیستمهای بینایی در حوزههای بحرانی مانند سیاستگذاری تطبیق یافتهاند زیرا انحراف سیستمهای تجسس باعث میشود اقلیتها به اشتباه بهعنوان مجرم شناسایی شوند.

پروژهای بهنام ImageNet در سال ۲۰۱۲، با قرار دادن کتابخانهای وسیع در اختیار توسعهدهندگان برای تشخیص مفاهیم بصری، نقشی کلیدی را در استفاده از پتانسیل هوش مصنوعی ایفا کرد. کتابخانهی یادشده شامل انواع تصاویر از گل تا اسنوبورد بود. دانشمندان استنفورد، پرینستون و دانشگاه کارولینای شمالی با پرداخت مبلغی اندک به کارگرهای مکانیکی از آنها برای برچسبگذاری بیش از ۱۴ میلیون تصویر استفاده کردند و در نهایت این مجموعهی عظیم را بهصورت رایگان منتشر کردند.

با ورود مجموعهی یادشده به یک شبکهی عصبی بزرگ، سیستم تشخیص تصویر قادر به شناسایی اشیا با دقت بسیار بالایی شد. الگوریتم از میان تعداد انبوه نمونهها به شناسایی الگوهایی پرداخت که شامل مفاهیم سطح بالایی مثل پیکسلهای تشکیلدهندهی بافت و شکل سگهای کوچک بود. رقابتی برای تست الگوریتمهای توسعهیافته با ImageNet آغاز شد. این رقابت نشان میداد بهترین الگوریتمهای یادگیری عمیق بهدرستی و با دقت انسانی به طبقهبندی صحیح تصاویر میپردازند. موفقیت سیستم مبتنی بر ImageNet زمینهساز موج جدیدی از هیجان و سرمایهگذاری در هوش مصنوعی و همچنین پیشرفت در حوزههای دیگر از جمله فناوریهای جدید، دوربینهای تلفن هوشمند و وسایل نقلیهی خودکار شد.

از طرفی پژوهشگرهای دیگری در سالهای اخیر، به مشکلاتی در دادههای ImageNet پی بردند. برای مثال ممکن است الگوریتم اینگونه آموخته باشد که برنامهنویسها صرفا مردان سفیدپوست هستند، دلیل این تشخیص، دقت پائین تصاویر با برچسب «برنامهنویس» است. یکی از پروژههای اخیر وب بهنام حفاری هوش مصنوعی (Excavating AI) بر پیشداوری در برچسبهای افزوده شده به ImageNet تأکید میکند که شامل طیف گستردهای از «رادیولوژیست» و «خیمهشبباز» تا فحشهای نژادی مانند «کاکا سیاه» است. افراد از طریق وبسایت پروژه میتوانند تصویر را ثبت کنند و عبارتهای ورودی به مدل AI را مشاهده کنند که براساس مجموعهی دادهها آموزش دیده است. دلیل وجود چنین انحرافاتی میتواند اشخاص اضافهکنندهی برچسب باشد. برای مثال ممکن است آنها اصطلاحی نادرست را به برچسبی مثل «معلم» یا «زن» اضافه کرده باشند.

تیم ImageNet برای پیبردن به منابع متعدد انحراف، به تحلیل دادههای خود پرداختند و سپس گامهایی را برای حل آنها برداشتند. آنها از روش جمعسپاری برای شناسایی و حذف کلمات مضر استفاده کردند. همچنین به شناسایی اصطلاحاتی پرداختند که معنایی را به تصویر نسبت میدهند (برای مثال کلمهی بشردوست) و سپس این اصطلاحات را از آموزش AI کنار گذاشتند.

تیم ImageNet همچنین به ارزیابی تنوع جغرافیایی و آماری در تصاویر پرداختند و ابزاری را برای جستجوی تصاویر متنوعتر توسعه دادند. برای مثال، اصطلاح «برنامهنویس» معمولا میتواند شامل تصاویر زیادی از مردان سفیدپوستی باشد که در مقابل کامپیوتر نشستهاند؛ اما با ابزار جدید که قرار است در ماههای آینده منتشر شود، زیرمجموعهای از تصاویر با تنوع نژاد، جنسیتی و سنی بیشتر تولید میشوند و برای آموزش به الگوریتم AI به کار میروند.

هوش مصنوعی هنوز هم برای عملکرد صحیح نیاز به کمک انسانی دارد

درنتیجه میتوان برای رسیدن به نتایج عادلانهتر، فرایند مهندسی مجدد را روی AI پیادهسازی کرد؛ اما باز هم AI به آموزش انسانی وابسته بوده و مسئلهی انحراف، اغلب اوقات چالشبرانگیز و پیچیده است. آندری باربو، دانشمند و پژوهشگر MIT که به بررسی ImageNet پرداخته است، این تلاش را ستودنی میخواند اما تأکید میکند که تعداد تصاویر مجموعهی دادهای بر میزان حذف انحراف تأثیر میگذارند، زیرا ممکن است تعداد کمی از نمونهها توازن را بر هم بزنند. بهویژه وقتی هدف، محاسبهی انواع انحراف مثل جنسیت، نژاد و سن باشد، نادیده گرفتن انحراف میتواند کارایی مجموعهی دادهای را کاهش داد. باربو میافزاید: «ساخت مجموعهی دادهای که فاقد انحرافهای مشخص باشد میتواند بهسرعت دادهها را به بخشهای کوچکی تبدیل کند و به این ترتیب چیزی نمیماند.»

روساکفسکی هم با پیچیدگی مشکل موافق است. باتوجه به ذهنیت فرهنگهای مختلف نسبت به دنیا، او تعریف شفافی را از مجموعهی تصویر متنوع ارائه نمیدهد. در نهایت او معتقد است، تلاش برای افزایش عدالت هوش مصنوعی بالاخره موفق خواهد شد و میگوید:

من نسبت به عادلانه شدن تصمیمگیری خودکار خوشبین هستم. انحراف زدایی انسانها دشوارتر از انحرافزدایی سیستمهای هوش مصنوعی است.

منبع : زومیت

دیدگاه ها